Un vuelo de Nueva York a Londres suele costar mucho más si se reserva desde una dirección IP en Manhattan que desde una dirección IP en Bombay. Una búsqueda en Google de "mejor pizza” produce resultados completamente diferentes en Tokio que en Osaka.

Internet no es un espacio uniforme. Cambia según tu perspectiva.

Para empresas globales, analistas de datos y desarrolladores, acceder a internet desde una única ubicación ya no es suficiente. Necesitan ver lo que ven sus clientes, exactamente donde están.

Esto requiere un web scraping geolocalizado. Sin él, se visualiza una versión genérica y esterilizada de la web que no refleja las condiciones reales del mercado.

Para obtener información precisa, es necesario viajar virtualmente hasta la fuente.

Por qué la recopilación de datos localizados lo cambia todo en línea

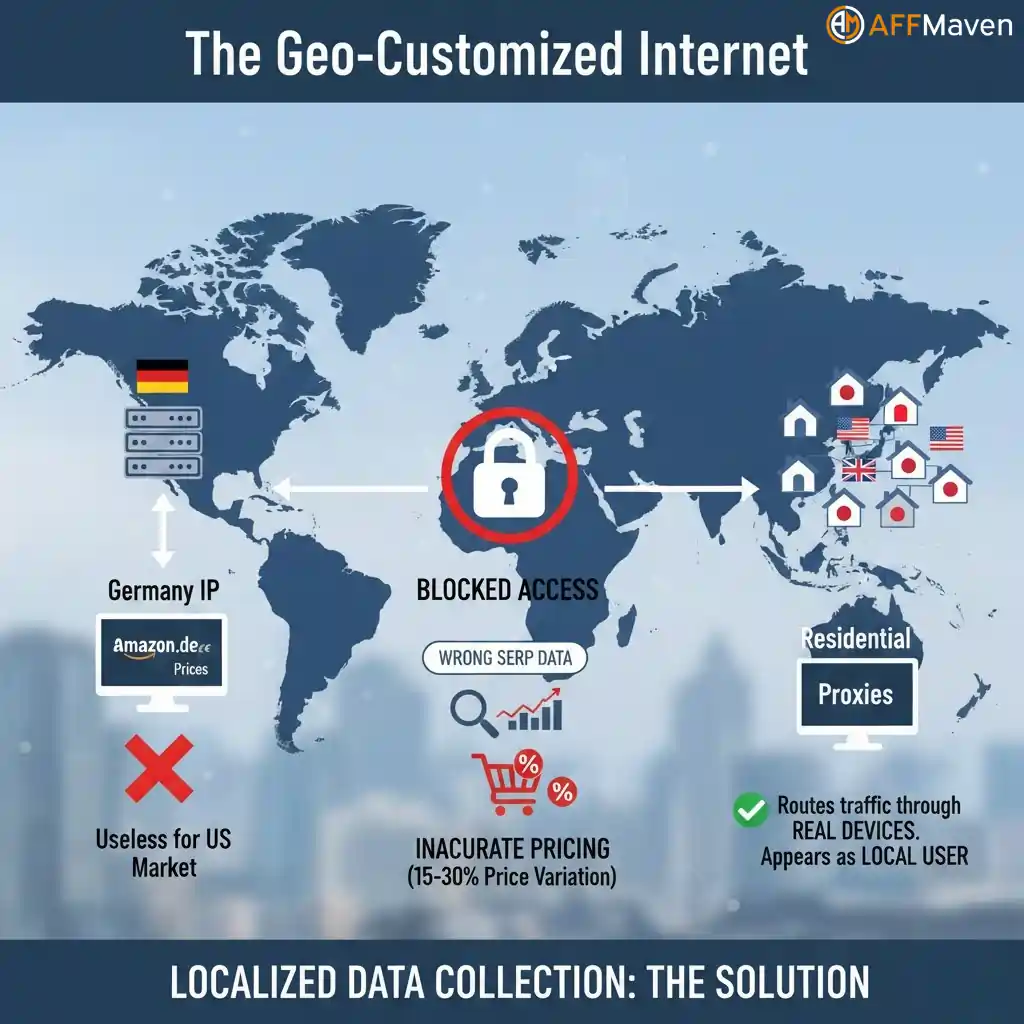

Internet no es estático. Los sitios web cambian su contenido según dónde creen que te encuentras. Esto se conoce como “bloqueo geográfico" o "geo-personalización".

Si raspar Amazon Al usar un servidor en Alemania, obtienes precios en euros y estimaciones de envío a Europa. Si tu mercado objetivo es Estados Unidos, esos datos son inútiles.

Precio dinamico Es el factor más importante. Las plataformas de comercio electrónico ajustan los costos según la demanda, el poder adquisitivo y la competencia local. Los estudios muestran que los precios en línea varían entre un 15 % y un 30 % según el usuario. Ubicación IP.

Sin una recopilación de datos hiperlocales, se enfrentan a tres riesgos principales:

Para solucionar esto, necesitas proxies residenciales por país. Estas herramientas dirigen tu tráfico a través de dispositivos reales en tu área objetivo, haciendo que tu bot parezca un usuario local.

Cómo los proxies residenciales permiten una navegación local real

Para que un scraper en Londres parezca que está navegando desde Chicago, la solución es usar proxies de alta calidad, específicamente proxies residenciales por país.

A diferencia de los servidores proxy de centros de datos, que se detectan fácilmente, los servidores proxy residenciales utilizan direcciones IP asignadas a dispositivos reales (como el Wi-Fi doméstico) por Proveedores de servicios de Internet (ISP)Esto hace que el tráfico parezca orgánico y humano.

Los proveedores avanzados utilizan una arquitectura de "retroconexión". En lugar de gestionar miles de listas de proxy individuales, se conecta a un único punto de entrada. Controla la ubicación de salida simplemente modificando su nombre de usuario.

Esta capacidad es esencial para las empresas que necesitan raspar resultados de búsqueda locales o verificar ubicaciones de anuncios en mercados específicos.

DecodoAlcance global, precisión local

Al realizar publicidad geosegmentada web scrapingLa cobertura lo es todo. No puedes conseguir vuelos baratos en Brasil si tu proveedor solo tiene IP en Europa.

Decodo ofrece una infraestructura construida para esta necesidad específica.

Esta infraestructura es vital para tareas como Raspado de Google Maps, donde la proximidad a la ubicación de búsqueda determina los resultados.

Estrategia paso a paso para el scraping localizado

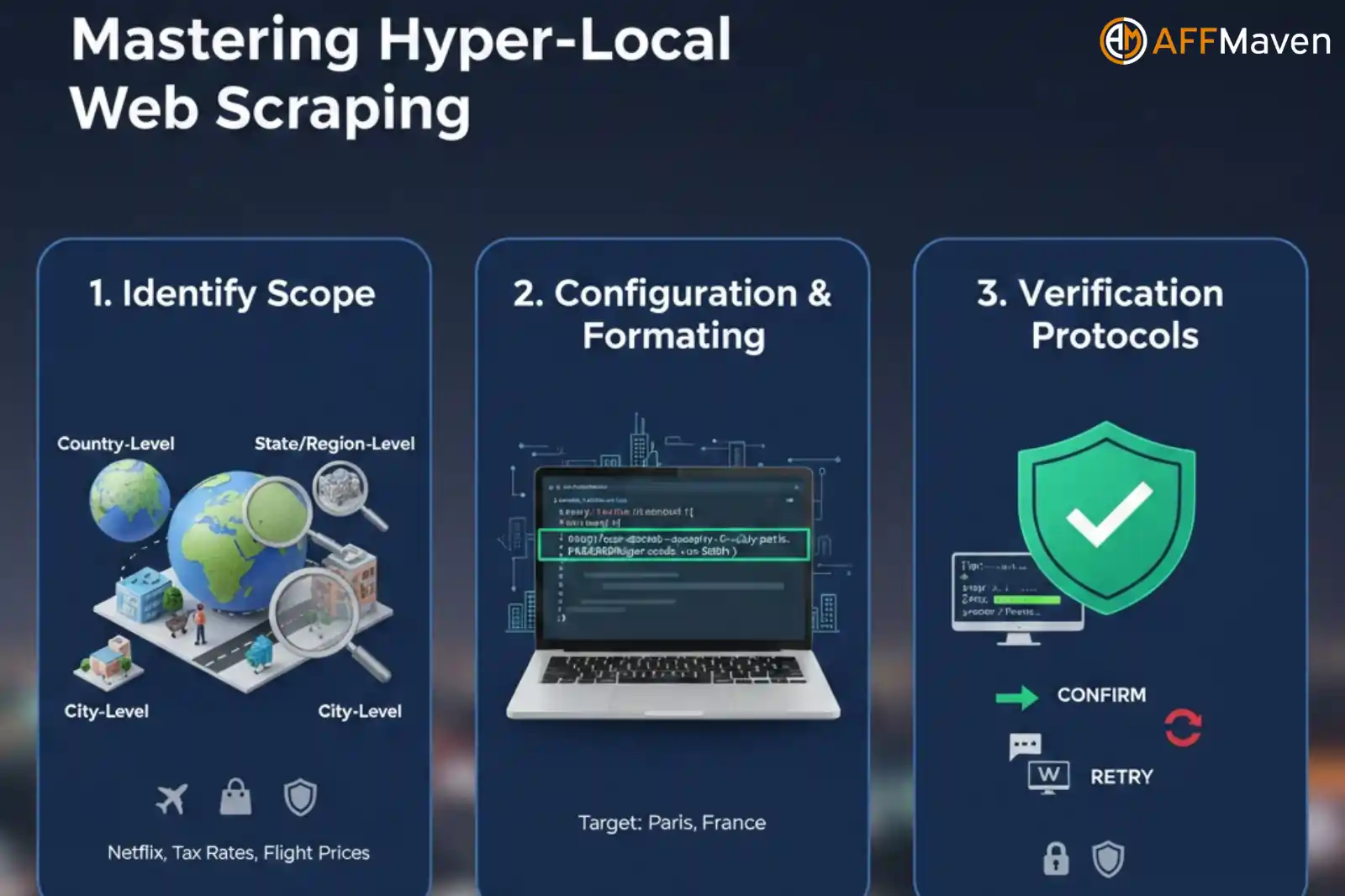

Implementar una exitosa raspado basado en la ubicación La operación consta de tres fases críticas. Seguir esta estructura garantiza altas tasas de éxito y precisión de los datos.

Paso 1: Identifique su alcance

Antes de escribir el código, defina el nivel de precisión que exige su proyecto.

Consejo: No pague por precisión a nivel de ciudad si basta con la precisión a nivel de país. Sin embargo, para SEO y comercio minorista, suele ser necesario tener precisión a nivel de ciudad.

Paso 2: Configuración y formato

Configuración Web scraping con Decodo Es sencillo. No requiere instalaciones de software complejas. Funciona mediante software estándar. protocolos de autenticación de proxy.

Aquí le mostramos cómo formatear su solicitud para orientarla a una ubicación específica.

Concepto: En lugar de simplemente enviar nombre de usuario:contraseña, envía nombre de usuario-país-OBJETIVO:contraseña.

Ejemplo de código (Python):

Aquí se explica cómo formatear la cadena de proxy para Ciudades proxy como objetivo:

python

import requests

# Target: Paris, France

# Format: user-decodo-country-[country_code]-city-[city_name]

proxies = {

"http": "http://user-decodo-country-fr-city-paris:[email protected]:8000",

"https": "http://user-decodo-country-fr-city-paris:[email protected]:8000",

}

url = "https://www.example.com"

response = requests.get(url, proxies=proxies)

print(response.text)Al utilizar este método, puede recorrer una lista de ciudades (Londres, Nueva York, Tokio, Berlín) y recopilar los datos exactos que ve un residente local en cada metrópolis.

Paso 3: Protocolos de verificación

La confianza es buena; la verificación es mejor.

Al ejecutar un script para Raspar precios de vuelos por ubicación, no puedes permitirte el lujo de adivinar si el rotación de proxy Funcionó. Debes confirmarlo.

Antes de que el scraper acceda al sitio web objetivo (como una aerolínea o un minorista), debería realizar una llamada preliminar a una API de verificación. Servicios como ipinfo.io o whoer.net devuelven datos JSON que muestran tu IP pública actual y su ubicación estimada.

Implementación de una verificación

Programa tu raspador para que acceda primero a la API de verificación.

Este paso garantiza que su recopilación de datos hiperlocales permanece libre de geolocalizaciones incorrectas.

Tácticas avanzadas: manejo de datos geográficos a gran escala

Al escalar el scraping localizado, se enfrentan a desafíos únicos. La gestión de sesiones y la rotación de IP se vuelve crucial.

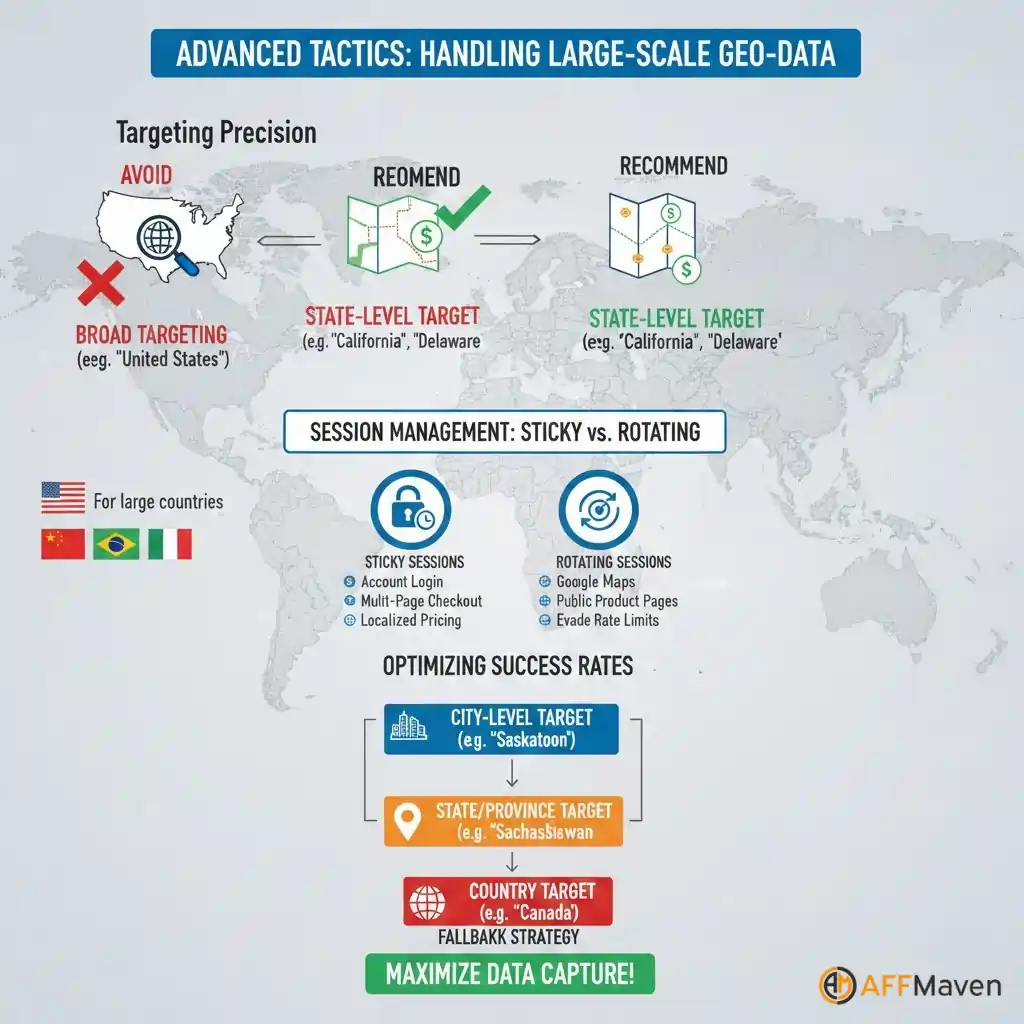

Evite la segmentación amplia para datos específicos

Un error común es usar “Estados Unidos” segmentación genérica cuando necesita tasas impositivas o costos de envío precisos.

California tiene normas de impuestos sobre las ventas diferentes a las de Delaware. Si usa un proxy genérico de EE. UU., podría obtener una IP en Delaware y perder por completo los datos fiscales. Utilice siempre la segmentación por estado para países grandes como EE. UU., India, Brasil o China.

Sesiones fijas vs. rotativas

Decodo le permite elegir entre sesiones persistentes (manteniendo la misma IP durante un tiempo determinado) y sesiones rotativas (nueva IP por solicitud).

- Utilice sesiones rotativas: Al extraer resultados de Google Maps o páginas públicas de productos, cambiar rápidamente las IP ayuda a evadir los límites de velocidad y a capturar datos con mayor rapidez.

- Utilice sesiones persistentes: Al iniciar sesión en cuentas o navegar por un proceso de pago de varias páginas para extraer precios locales, cambiar las IP a mitad de la sesión puede... activar alertas de seguridad.

Optimización de las tasas de éxito

A veces, una ciudad específica puede tener menos usuarios activos en línea. Si solicitas específicamente "Saskatoon, Canadá" y el grupo es reducido, las solicitudes podrían ser rechazadas.

Estrategia: Comience con una segmentación proxy estricta a nivel de ciudad. Si se agota el tiempo de espera de las solicitudes, configure su código para volver a la segmentación por estado/provincia y, finalmente, a la segmentación por país. Esta cascada garantiza la obtención de datos incluso si el nodo de la ciudad exacta no está disponible temporalmente.

Convierta los datos globales en inteligencia de mercado local

La precisión de los datos depende del contexto. Un precio solo es preciso si se conoce dónde Ese precio aplica. Un ranking de búsqueda solo es real si sabes quién lo ve.

Decodo Proporciona la infraestructura para responder a estas preguntas. Con un conjunto de datos que abarca 195 ubicaciones y la capacidad de analizar ciudades específicas, eliminamos los puntos ciegos geográficos.

No se conforme con promedios globales genéricos. Utilice el rastreo web geográfico para ver el mercado tal como es. No importa si necesita monitorear proxies residenciales por país para verificar el cumplimiento o ejecutar una segmentación exhaustiva a nivel de ciudad. inteligencia de precios, la capacidad está disponible.

Ya no tienes que adivinar cómo es el mercado local. Simplemente puedes estar presente.

Affiliate Divulgación: Esta publicación puede contener alguna affiliate enlaces, lo que significa que podemos recibir una comisión si compras algo que recomendamos sin costo adicional para ti (¡ninguno en absoluto!).