إذا كنت جادًا بشأن الحصول على تصنيف أعلى في عام 2026، فلا يمكنك تجاهلكاشطات SERP. أصبحت هذه الأدوات الآن السلاح السري لأفضل affiliateالمسوقون ومحترفو تحسين محركات البحث ومشتري الوسائط الذين يريدون تتبع بيانات البحث المباشرة ورصد اتجاهات الكلمات الرئيسية والهندسة العكسية لما ينجح بالفعل مع منافسيهم.

أكثر من ثلاثة أرباع يستخدم المسوقون الرقميون بالفعل أدوات كشط نتائج البحث (SERP) لتتبع الكلمات الرئيسية ومراقبة مواضع الإعلانات المنافسة. لكن إليكَ المفاجأة: ليست جميع أدوات كشط نتائج البحث (SERP) متساوية، واستخدام الأداة الخاطئة (أو استخدامها بطريقة خاطئة) قد يُوقعك في مشكلة. حظر عناوين IP أو حتى الصداع القانوني.

في هذا الدليل، سأشرح لك الطرق الأكثر ذكاءً لاستخدام أدوات كشط SERP في عام 2026، والأدوات التي تمنحك أنظف البيانات، وكيفية تجنب الأخطاء الشائعة - حتى تتمكن من البقاء في صدارة لعبة تحسين محركات البحث والحفاظ على حملاتك تعمل بكامل طاقتها.

ما هي SERP Scrapers؟

تُعد أدوات كشط صفحات نتائج محرك البحث (SERP) أدوات آلية، وغالبًا ما يُشار إليها باسم الروبوتات أو العناكب، المصممة لاستخراج البيانات من الصفحات تعرض محركات البحث النتائج استجابةً لاستعلام. تعمل هذه الأدوات على تحليل شيفرة HTML لصفحات نتائج البحث.

يمكنهم جمع أنواع مختلفة من المعلومات، بما في ذلك تصنيفات البحث العضوي والإعلانات المدفوعة التفاصيل وعناوين الصفحات وعناوين URL والأوصاف التعريفية، وميزات SERP الأخرى مثل مربعات "يسأل الناس أيضًا" أو المقتطفات المميزة.

في الأساس، تعمل أداة SERP scraper على أتمتة عملية جمع البيانات من نتائج محرك البحث، والتي قد تتطلب جهدًا يدويًا مكثفًا، مما يسمح جمع البيانات على نطاق وسرعة أكبر بكثير.

لماذا تعد SERP Scrapers مهمة في عام 2026؟

في عام 2026، ستكون أدوات كشط SERP بالغة الأهمية لأنها توفر إمكانية الوصول إلى بيانات دقيقة في الوقت الفعلي من محركات البحث، وهو أمر حيوي لاتخاذ قرارات مستنيرة في الصناعة الرقمية الديناميكية.

تتيح هذه البيانات للشركات والمسوقين إجراء حملات تسويقية فعالة تحليل السيو، تتبع تصنيفات الكلمات الرئيسية، ومراقبة أداء البحث واستراتيجيات المنافسين، وتحديد اتجاهات السوق.

غالبًا ما يتم جمع هذه البيانات يدويًا غير فعالة ويكاد يكون من المستحيل تحقيقها على نطاق واسع، وخاصة مع تطور واجهات محركات البحث.

تمكن أدوات SERP المؤسسات من تحسين حضورها على الإنترنت وتحسينها جهود تسويق المحتوى، تعزيز الحملات الإعلانية، والحصول على رؤى حول نتائج البحث المحلية من خلال جمع بيانات البحث وتحليلها بشكل منهجي.

أدوات SERP Scraping التي توفر رؤى تحسين محركات البحث في الوقت الفعلي

1. Oxylabs API مكشطة SERP

Oxylabs توفر SERP Scraper API، المتكاملة ضمن منصة Web Scraper API الخاصة بها، موثوقة، بيانات محرك البحث في الوقت الفعلي من 195 دولة. إنه يستخدم إدارة الوكيل التي تعتمد على الذكاء الاصطناعي وتقنيات مكافحة الحظر المتقدمة لجمع البيانات بكفاءة جوجل، بينج، بايدو، وياندكس، مما يجعلها مثالية لتحسين محركات البحث وتحليل السوق على نطاق واسع.

الملامح الرئيسيةهو:

| المواصفات التقنية | أيقونة |

|---|---|

| متوسط الاستجابة | |

| التغطية الجغرافية | 195 دولة |

| محركات | جوجل/بينج/ياندكس |

| الناتج | JSON/HTML/CSV |

الايجابيات:

سلبيات:

التسعير: Oxylabsتبدأ خطط Web Scraper API، التي تتضمن كشط SERP، من 49 دولارًا أمريكيًا شهريًا، ويتم الفوترة فقط مقابل النتائج المستردة بنجاح.

لماذا اخترنا Oxylabs: تضمن بنيتها التحتية القوية ومساعدة الذكاء الاصطناعي والميزات الشاملة موثوقية وقابلية التوسع جمع بيانات SERP للمشاريع الصعبة.

كيف تعمل Oxylabs SERP Scraper API: سجل على Oxylabs، قم بإنشاء بيانات اعتماد مستخدم API، ثم أرسل طلبات POST إلى https://realtime.oxylabsنقطة نهاية .io/v1/queries مع المصدر المطلوب (على سبيل المثال، google_search)، والاستعلام، ومعلمات الموقع الجغرافي.

2. Decodo SERP كشط API

Decodoتوفر واجهة برمجة تطبيقات SERP Scraping الخاصة بـ بيانات محرك البحث في الوقت الحقيقي, أتمتة إدارة البروكسي، وحل رموز التحقق، وتجنب حظر عناوين IP. الوصول منظم. نتائج JSON أو HTML من أكثر من 195 موقعًا حول العالم، مثالي لمحترفي تحسين محركات البحث ومحللي البيانات الذين يحتاجون إلى ذكاء SERP موثوق.

الميزات الرئيسية:

| المواصفات التقنية | أيقونة |

|---|---|

| معدل النجاح | 100% |

| متوسط الاستجابة | ~5-6 ثانية |

| المواقع | 195+ عالميًا |

| خرج تنسيقات | JSON/HTML/الجدول |

الايجابيات:

سلبيات:

التسعير: Decodoتبدأ أسعار واجهة برمجة تطبيقات SERP Scraping من 0.08 دولار أمريكي لكل 1 طلب، كجزء من واجهة برمجة تطبيقات Web Scraping حل.

لماذا اخترنا Decodo: Decodo تقدم واجهة برمجة تطبيقات SERP موثوقة وفعالة من حيث التكلفة مع استهداف جغرافي ممتاز ومعدل نجاح مرتفع للمشاريع المتنوعة.

كيف تعمل Decodo واجهة برمجة تطبيقات كشط SERP: سجل على Decodoاحصل على بيانات اعتماد مصادقة واجهة برمجة التطبيقات الخاصة بك، وأرسل طلبات POST إلى https://scrape.decodoنقطة نهاية .com/v1/tasks، مع تحديد معلمات مثل الهدف والاستعلام والموقع والموقع الجغرافي.

3. ZenRows

تتميز ZenRows بكونها أداة كشط SERP الشاملة، يتجاوز بسهولة إجراءات مكافحة الروبوتات لتقديم بيانات منظمة من محركات البحث مثل جوجل. فهو يُؤتمت المهام المعقدة، ويوفر نتائج بحث موثوقة لـ تحليل محركات البحث وذكاء السوق، ضمان الخاص بك خط أنابيب البيانات يبقى دون انقطاع.

الميزات الرئيسية:

| المواصفات التقنية | أيقونة |

|---|---|

| متوسط معدل النجاح | ~ 99.9٪ |

| المواقع الجغرافية | 190+ دولة |

| إخراج البيانات | JSON/HTML |

| عرض JS | عائلات |

- معدل تجاوز عالي لمكافحة الروبوتات.

- بيانات SERP منظمة وموثوقة.

- خيارات استهداف جغرافي واسعة النطاق.

- تكامل واجهة برمجة التطبيقات البسيطة.

- النسخة التجريبية المجانية لها حدود.

- قد يكون باهظ الثمن بالنسبة للمبتدئين.

التسعير: تبدأ الخطط من 69 دولارًا أمريكيًا شهريًا، مع توفر مستويات مختلفة؛ وتوفر النسخة التجريبية المجانية ما يصل إلى 1,000 طلب.

لماذا اخترنا ZenRows: إن نظام الذكاء الاصطناعي القوي المضاد للحظر ومعدلات النجاح العالية والتسليم الموثوق لبيانات SERP المنظمة تجعله الخيار الأفضل.

كيفية استخدام ZenRows:

4. واجهة برمجة تطبيقات Zyte

توفر واجهة برمجة تطبيقات Zyte حلاً شاملاً لـ استخراج بيانات الويب وSERP، التعامل تلقائيًا مع الحظر وعرض جافا سكريبت. التحليل المدعوم بالذكاء الاصطناعي يقدم بيانات منظمة من مواقع معقدة، وهو مثالي للشركات التي تحتاج إلى بيانات موثوقة، رؤى محرك البحث القابلة للتطوير وبيانات الويب دون إدارة الوكيل اليدوية.

الميزات الرئيسية:

| المواصفات التقنية | أيقونة |

|---|---|

| إدارة الحظر | الآلي |

| عرض JS | مدمج |

| إخراج البيانات | منظمة (الذكاء الاصطناعي) |

| استهداف الجغرافية | نعم (البلد) |

الايجابيات:

سلبيات:

التسعير: تستخدم واجهة برمجة التطبيقات Zyte نموذج الدفع حسب الاستخدام؛ وتختلف التكاليف بناءً على تعقيد الطلب وحجمه.

لماذا اخترنا Zyte API: قدرتها الشاملة على إلغاء الحظر والتقديم و الاستخراج المدعوم بالذكاء الاصطناعي يُبسط عملية جمع بيانات SERP المعقدة بشكل فعال.

كيفية استخدام Zyte API: قم بالتسجيل للحصول على مفتاح API، ثم أرسل طلبات POST إلى نقطة النهاية /extract مع عنوان URL المستهدف والمعلمات المطلوبة، وتلقي البيانات المنظمة.

5. نود مافن

توفر NodeMaven وكلاء سكنيين ومتنقلين عالي الجودة مُحسّنين لـ كشط SERP ومراقبة تحسين محركات البحث. تضمن تقنية تصفية IP المتقدمة اتصالات نظيفة وموثوقة، تقليل الكتل و CAPTCHAs بينما نقوم بجمع بيانات دقيقة لمحركات البحث من أكثر من 150 دولة.

الميزات الرئيسية:

| المواصفات التقنية | أيقونة |

|---|---|

| عناوين IP السكنية | شنومكسم + |

| عناوين IP للجوال | 250K + |

| متوسط النجاح | 99.54% |

| معدل تنظيف IP | 95% |

الايجابيات:

سلبيات:

الأسعار:تقدم NodeMaven نسخة تجريبية مقابل 3.99 يورو (500 ميجابايت) وتبدأ الخطط من 30 يورو/الشهر مقابل 5 جيجابايت من حركة مرور الوكالة السكنية.

لماذا اخترنا NodeMaven:إن التركيز على عناوين IP عالية الجودة والمفلترة والجلسات اللاصقة الموثوقة يجعلها ممتازة لاستخراج بيانات SERP بشكل متسق.

كيفية استخدام NodeMaven:قم بالتسجيل، واختر خطة وكيل، وقم بتكوين أدوات أو تطبيقات الكشط الخاصة بك باستخدام عنوان الوكيل gate.nodemaven.com والمنفذ وبيانات الاعتماد الخاصة بك بروتوكولات HTTP أو SOCKS5.

كيفية تجنب حظر Google باستخدام SERP Scrapers؟

تستخدم محركات البحث، مثل جوجل، إجراءات متنوعة للكشف عن عمليات الاستخراج الآلية وحظرها. وللحد من فرص الحظر، يمكن استخدام عدة استراتيجيات:

- تدوير عنوان IP: يساعد تغيير عنوان IP المُستخدَم للطلبات بانتظام على منع الكشف، إذ إن الكميات الكبيرة من الطلبات من عنوان IP واحد قد تُؤدي إلى حظرها، ما يجعل الطلبات تبدو وكأنها واردة من مستخدمين مختلفين.

- محاكاة وكيل المستخدم: تستطيع برامج الكشط محاكاة متصفحات الويب الشرعية من خلال تغيير سلاسل بيانات وكيل المستخدم المُرسلة مع كل طلب. هذا يُصعّب تمييز الطلبات الآلية عن حركة مرور البيانات البشرية العادية.

- تقليد السلوك البشري: إن تقديم تأخيرات عشوائية بين الطلبات، وأنماط التفاعل العشوائية (مثل حركات الماوس إذا كنت تستخدم متصفحات بدون رأس)، والحد من معدل الطلب يمكن أن يجعل نشاط الكشط يبدو أكثر طبيعية وأقل تشابهًا مع الروبوتات.

- التعامل مع CAPTCHAs: تنفيذ آليات أو خدمات لحل المشكلات كبتشس (اختبار تورينج العام الآلي بالكامل للتمييز بين أجهزة الكمبيوتر والبشر) يمكن أن يساعد في تجاوز هذه التحديات الأمنية الشائعة، على الرغم من أن هذا إجراء رد فعل.

- احترام سياسات الموقع: من المهم مراجعة شروط خدمة الموقع الإلكتروني وملف robots.txt، والالتزام بهما قدر الإمكان، حيث قد يحدد قواعد الوصول الآلي. يجب إجراء عملية الكشط بمسؤولية لتجنب زيادة تحميل الخوادم.

- استخدم المتصفحات بدون رأس (عند الضرورة): بالنسبة للصفحات التي تم تحميل المحتوى بها بواسطة JavaScript، يمكن للمتصفحات بدون رأس عرض الصفحة بالكامل قبل استخراج البيانات، مما يضمن جميع محتوى ديناميكي يتم التقاطها، على غرار الطريقة التي يعرضها بها متصفح المستخدم.

من خلال استخدام هذه التقنيات، يمكن للمستخدمين زيادة موثوقية واتساق جهود جمع بيانات SERP الخاصة بهم مع تقليل احتمالية مواجهة الكتل.

اختيار أفضل أداة لكشط نتائج البحث (SERP)

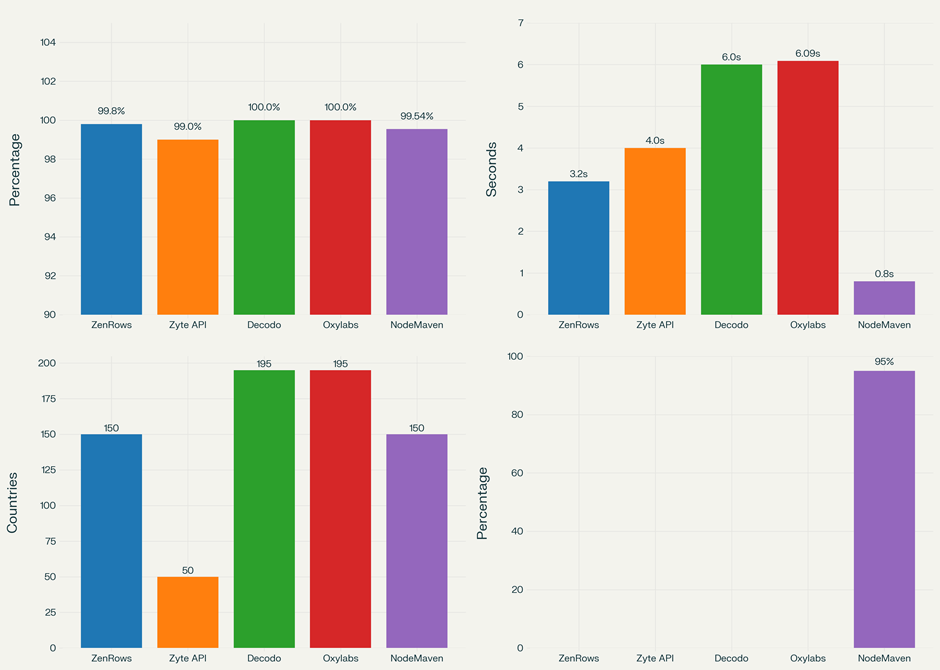

اختيار أداة استخراج نتائج البحث (SERP) المناسبة في عام ٢٠٢٥ يعني إيجاد أداة موثوقة للحصول على بيانات البحث. توفر الأدوات الجيدة قوي مضاد للحجب, نتائج منظمة، وتغطي العديد من المواقع.

ابحث عن ارتفاع معدلات النجاح (أكثر من 99%) وتسليم البيانات بسرعة (0.8 إلى 6 ثوانٍ)سواءً كانت المهام كبيرة أو صغيرة، توفر أدوات جمع البيانات الحديثة وصولاً سهلاً إلى معلومات البحث، مع الموازنة بين التكلفة والميزات. اختر بناءً على حجم مشروعك وميزانيتك.

Affiliate إفشاء: قد تحتوي هذه التدوينة على بعض affiliate الروابط، مما يعني أننا قد نتلقى عمولة إذا قمت بشراء شيء نوصي به دون أي تكلفة إضافية لك (لا شيء على الإطلاق!)