الحصول على كتل IP ومعدل liقد يؤدي استخدام mits أثناء عملية الكشط إلى إتلاف مشاريعك بسرعة. تفشل قوائم الوكلاء المجانية خلال ساعات، ويتحول كود التدوير اليدوي إلى فوضى عارمة. بناء كاشط ويب في بايثون الذي يظل غير مكتشف يتطلب وكلاء دوارين يتصرفون مثل المستخدمين الحقيقيين.

تحل وكلاء السكن هذه المشكلة عن طريق تبديل عناوين IP تلقائيًا، وتجاوز أنظمة مكافحة الروبوتات دون الحاجة إلى تعليمات برمجية إضافية.

سنوضح لك كيفية إعداد دوران الوكيل باستخدام Decodo، تحويل مكشطة البيانات الخاصة بك إلى آلة جمع بيانات لا يمكن إيقافها.

فهم آليات دوران الوكيل

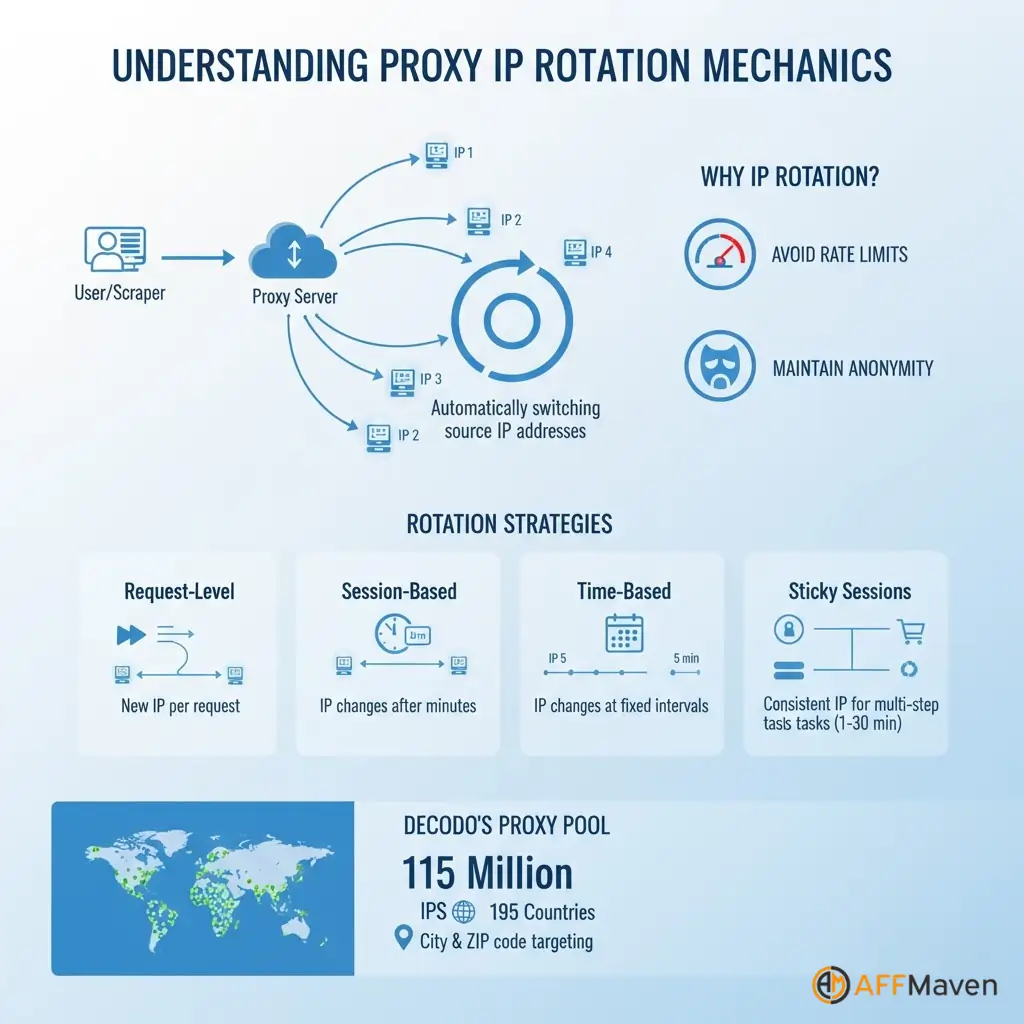

تدوير عناوين IP يعني تبديل عنوان IP المصدر تلقائيًا لكل طلب أو بعد فترات زمنية محددة. توزع هذه التقنية حمل الاستخلاص على عناوين متعددة، مما يمنع أي عنوان IP واحد من فرض قيود على السرعة.

تخدم استراتيجيات التدوير المختلفة احتياجات مختلفة:

تحتفظ الجلسات الملتصقة بعنوان IP واحد نشطًا مؤقتًا للعمليات متعددة الخطوات مثل تسجيل الدخول إلى الحسابات أو إكمال المعاملات.

Decodo يدعم الجلسات اللاصقة التي تستمر من دقيقة واحدة إلى 30 دقيقة، مما يمنحك المرونة لسير العمل المعقد.

يوفر مفهوم تجمع الوكيل إمكانية الوصول إلى ملايين عناوين IP السكنية من الأجهزة الحقيقية في جميع أنحاء العالم. Decodo تحافظ على مجموعة مكونة من 115 مليون عنوان IP تمتد عبر 195 دولة مع استهداف دقيق يصل إلى مستوى المدينة والرمز البريدي.

لماذا يؤدي الدوران اليدوي إلى إنشاء مشاكل

يبدو أن بناء منطق دوران البناء يدويًا سهل، لكنه يُسبب مشاكل صيانة. عليك وكيل المصدر قوائم باستمرار، لأن وكلاء البروكسي المجانيين يتلفون بسرعة. اختبار كل وكيل قبل استخدامه يزيد من زمن الوصول لكل طلب.

تشكل قوائم الوكلاء المجانية مشكلات خطيرة:

يتطلب التدوير اليدوي برمجة مخصصة لاختيار الوكلاء، واكتشاف الأعطال، وإزالة عناوين IP غير الصالحة، وإعادة محاولة الطلبات. هذا العمل المتعلق بالبنية التحتية يُشتت الانتباه عن التنفيذ الفعلي. استخراج البيانات المهام.

الدوران الذكي مع Decodo وكلاء سكني

Decodo يبسط كل شيء مع الإدارة مجموعات الوكيل تحتوي على 115 مليون عنوان IP سكني يتم صيانتها تلقائيًا عبر 195 موقعًا.

توفر الخدمة تدويرًا تلقائيًا مدمجًا في نقطة نهاية الوكيل، ومراقبة الصحة التي تزيل عناوين IP الميتة، والاستهداف الجغرافي للبلد أو المدينة أو الرمز البريدي دقة المستوى.

| الميزات | دوران يدوي | Decodo الحلول |

|---|---|---|

| حجم تجمع IP | محدودة وغير مستقرة | أكثر من 115 مليون عنوان IP سكني |

| الدورية | التحديثات اليدوية مطلوبة | مراقبة الصحة التلقائية |

| معدل النجاح | متغير، منخفض في كثير من الأحيان | 99.86 نسبة النجاح٪ |

| استهداف الجغرافية | غير متوفرة | الدولة، المدينة، الرمز البريدي، ASN |

| وقت الإعداد | ساعات التكوين | الدقائق مع واجهة برمجة التطبيقات |

التسجيل للحصول على Decodo حساب انتقل إلى لوحة معلومات الوكيل. انسخ اسم المستخدم وكلمة المرور ونقطة النهاية والمنفذ من قسم بيانات الاعتماد.

pip install requests beautifulsoup4 lxmlimport requests

from bs4 import BeautifulSoup

import random

# Decodo rotating residential proxy configuration

DECODO_HOST = 'gate.decodo.com'

DECODO_PORT = 7000

DECODO_USERNAME = 'your_username'

DECODO_PASSWORD = 'your_password'

# Create session ID for sticky sessions

session_id = random.randint(1000, 9999)

# Format proxy URL with session management

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {

'http': proxy_url,

'https': proxy_url

}

def scrape_with_rotating_proxy(url):

"""Scrape URL using Decodo rotating residential proxy"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'

}

try:

response = requests.get(url, proxies=proxies, headers=headers, timeout=30)

response.raise_for_status()

soup = BeautifulSoup(response.content, 'lxml')

return soup

except requests.exceptions.RequestException as e:

print(f"Error scraping {url}: {e}")

return None

# Scrape multiple URLs with automatic rotation

urls_to_scrape = [

'https://example.com/page1',

'https://example.com/page2',

'https://example.com/page3'

]

for url in urls_to_scrape:

data = scrape_with_rotating_proxy(url)

# Process extracted dataDecodo يتعامل مع دوران IP تلقائيًا مع كل معرف جلسة جديد، يتم التخلص من المنطق اليدوي.

توجيه الطلبات نحو الاستهداف الجغرافي عبر بلدان أو مدن محددة:

# Route through US residential IPs only

proxy_url = f'http://{DECODO_USERNAME}-country-us:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

# City-level targeting

proxy_url = f'http://{DECODO_USERNAME}-city-newyork:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'تحافظ إدارة الجلسة للجلسات الملتصقة على نفس عنوان IP عبر طلبات متعددة:

# Use same proxy for 10 to 20 requests before generating new session

session_id = random.randint(1000, 9999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'يؤدي الدوران على مستوى الطلب إلى توليد أقصى قدر من تنوع IP:

def get_fresh_proxy():

session_id = random.randint(1000, 99999)

return f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'import time

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retry

def create_session_with_retries():

"""Create requests session with automatic retries"""

session = requests.Session()

retry_strategy = Retry(

total=3,

backoff_factor=1,

status_forcelist=[429, 500, 502, 503, 504]

)

adapter = HTTPAdapter(max_retries=retry_strategy)

session.mount("http://", adapter)

session.mount("https://", adapter)

return session

def robust_scrape(url, max_retries=3):

"""Scrape with automatic proxy rotation and error handling"""

session = create_session_with_retries()

for attempt in range(max_retries):

session_id = random.randint(1000, 99999)

proxy_url = f'http://{DECODO_USERNAME}-session-{session_id}:{DECODO_PASSWORD}@{DECODO_HOST}:{DECODO_PORT}'

proxies = {'http': proxy_url, 'https': proxy_url}

try:

response = session.get(url, proxies=proxies, timeout=30)

if response.status_code == 200:

return BeautifulSoup(response.content, 'lxml')

else:

print(f"Status {response.status_code} on attempt {attempt + 1}")

time.sleep(2 ** attempt)

except Exception as e:

print(f"Attempt {attempt + 1} failed: {e}")

time.sleep(2 ** attempt)

return Noneالتحسين وأفضل الممارسات

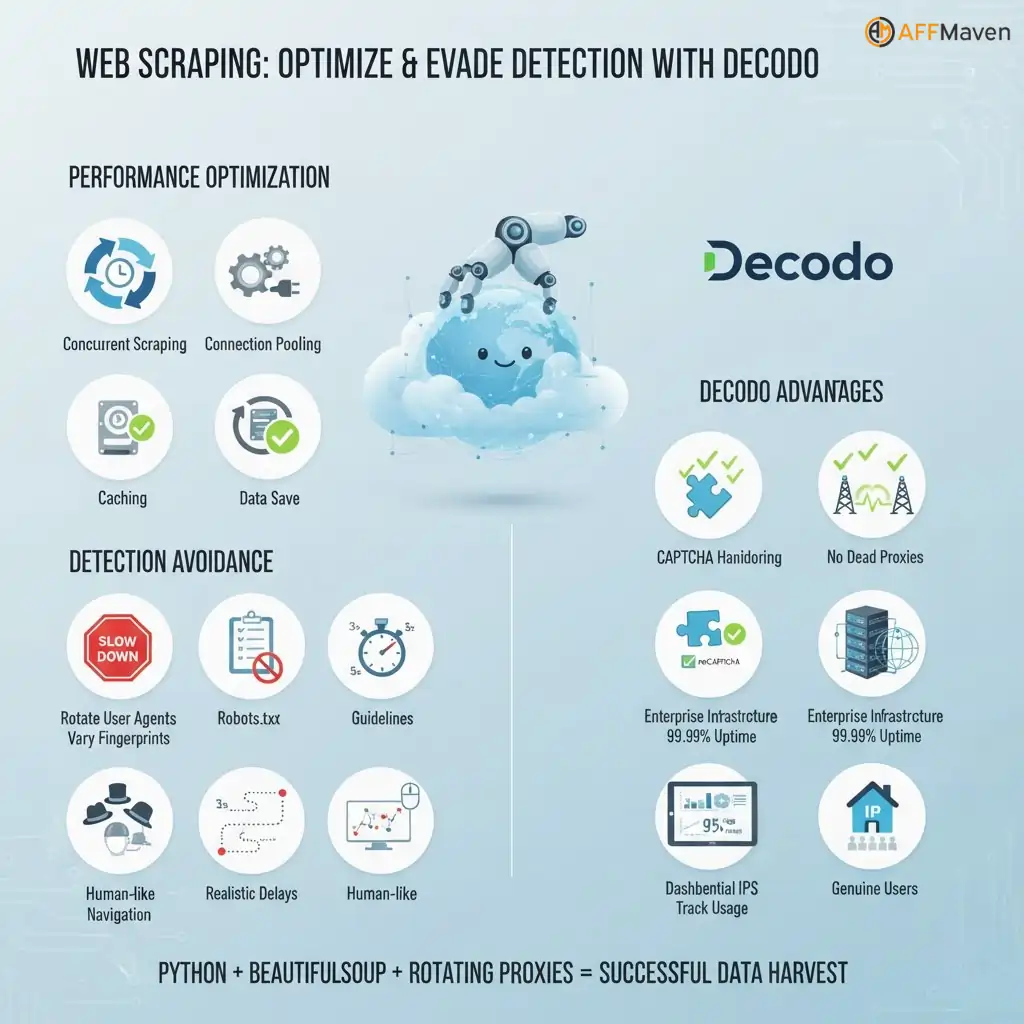

تحسين الأداء تتضمن التقنيات الكشط المتزامن مع الترابط من أجل السرعة، وتجميع الاتصالات لإعادة استخدام اتصالات TCP، وتخزين جلسات الوكيل الناجحة، والحد من المعدلات بشكل محترم.

تجنب الكشف خارج نطاق الوكلاء:

Decodo- مزايا محددة:

كشط الويب باستخدام بايثون يؤدي استخدام BeautifulSoup وتدوير الوكلاء إلى إنشاء أدوات كشط جاهزة للإنتاج تتجاوز الكتل وتتعامل مع CAPTCHAs وتصل إلى المحتوى المقيد جغرافيًا.

أكثر من Decodo توفر خدمة الوكيل عناوين IP سكنية تظهر كمستخدمين حقيقيين، مما يضمن معدلات نجاح عالية لمشاريع جمع البيانات واسعة النطاق.

جعل مكشطة الخاص بك مضادة للرصاص

لديك الآن أداة استخراج بيانات ويب إنتاجية تتعامل مع 115 مليون عنوان IP عبر 195 موقعًا. يقوم الكود الخاص بك بتدوير العناوين تلقائيًا، ويتجاوز اختبارات CAPTCHA، ويحافظ على نسبة نجاح 99.86% دون تدخل يدوي.

أكثر من استراتيجية الدوران بالوكالة يُزيل نظامك المُنشأ العوائق ويُحافظ على استمرارية جمع بياناتك على مدار الساعة. ابدأ بالتجربة المجانية لاختبار إعداداتك، ثم توسّع لتلبية آلاف الطلبات في الساعة.

ما هو الموقع الذي ستقوم باستخراجه أولاً باستخدام أداة الكشط الجديدة غير القابلة للحظر؟

Affiliate إفشاء: قد تحتوي هذه التدوينة على بعض affiliate الروابط، مما يعني أننا قد نتلقى عمولة إذا قمت بشراء شيء نوصي به دون أي تكلفة إضافية لك (لا شيء على الإطلاق!)